Alege o etichetă din

Actualitate

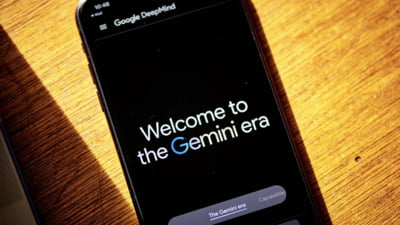

Inteligența artificială, păcălită ca un om: metode noi de atac ocolesc filtrele de siguranță și generează răspunsuri periculoase

Sistemele de inteligență artificială pe care ne bazăm tot mai mult, fie că vorbim despre ChatGPT, Claude, Gemini sau Meta AI, pot fi înșelate. Asta reiese dintr-un avertisment oficial emis de CERT Coordination Center, care detaliază două tehnici noi prin care modelele AI pot fi forțate să furnizeze răspunsuri ilegale, toxice sau pur și simplu greșite. Practic, ceea ce părea un asistent virtual controlat și previzibil se dovedește mult mai vulnerabil în fața unor interacțiuni atent construite.

Economie• Citește știrea pe ziare.com